AI 日刊 20251212

产品发布与更新

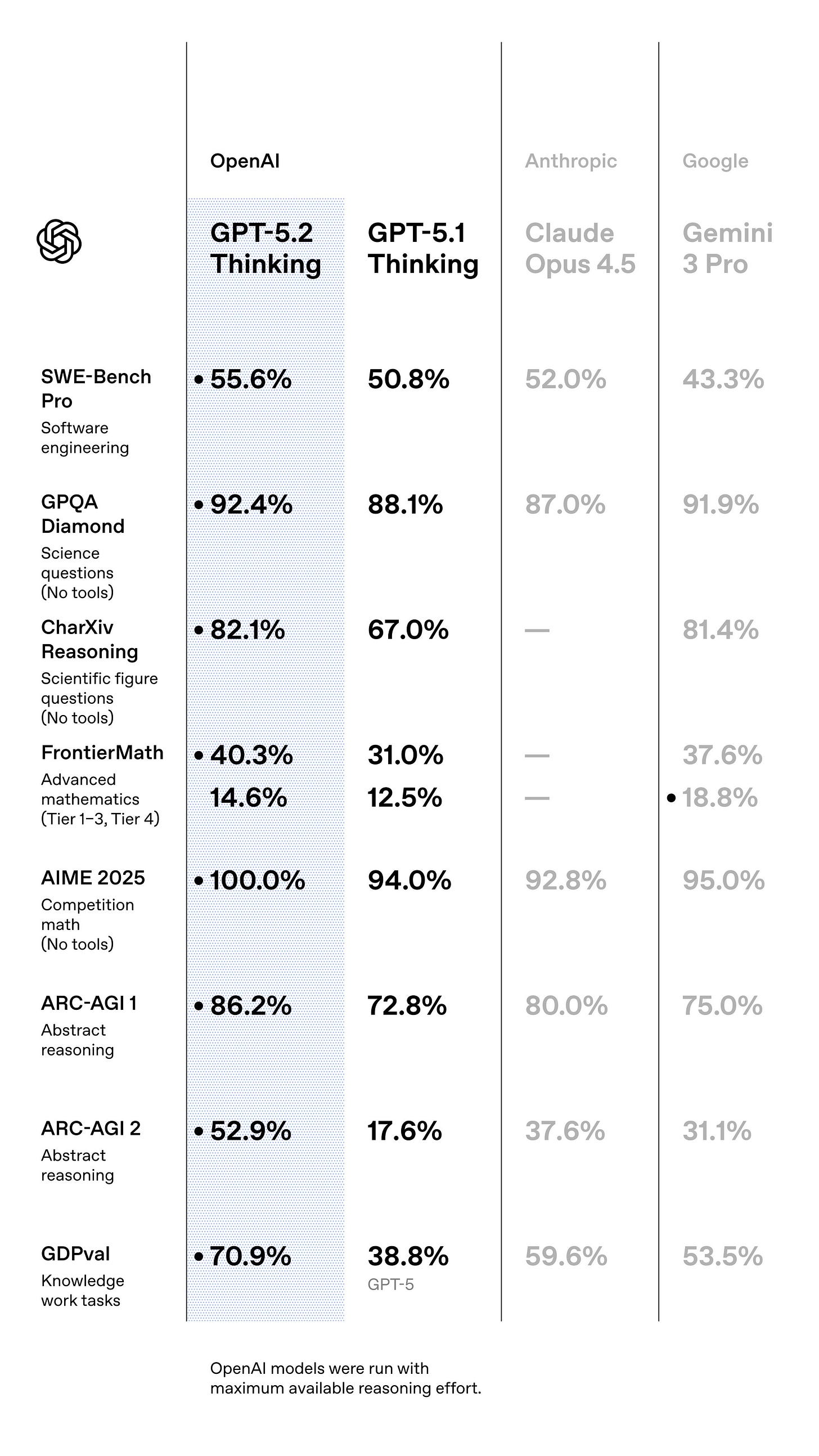

GPT‑5.2 正式发布,主打真实知识工作。OpenAI 推出 GPT‑5.2 家族,已在 ChatGPT 与 API 全面上线,重点强化长文档推理、编码和电子表格/演示文稿等“真实世界知识工作”场景。Sam Altman 称这是自 GPT‑5.1 以来最大升级,并强调在过去一年实现了约 390 倍成本下降,意味着更强模型正在快速走向“人人用得起”的专业助手。消息来源

Grok 成为萨尔瓦多全国 AI 家教。xAI 宣布与萨尔瓦多政府合作,将个性化 Grok 家教带入全国所有公立学校,为超过 100 万学生提供一对一辅导,被称为全球首个“全国级 AI 家教计划”。这标志着大模型从实验性产品走向国家级教育基础设施的第一步,未来极可能成为其他国家仿效模板。消息来源

Cursor 支持直接“在代码里设计界面”。Cursor 新增可视化设计能力:开发者可以在浏览器里选中页面元素,拖拽、调整样式,Cursor 自动生成并回写对应代码。配合其浏览器可视编辑器和自动测试能力,前端开发从“写代码调样式”变为“所见即所得地拉 UI”,非常适合快速迭代营销页与后台面板。消息来源

GPT‑5.2 快速登陆主流开发工具与终端。新模型已在 Cursor、Warp、Windsurf、Notion、Perplexity、GitHub AgentHQ 等工具中上线,其中 Cursor 直接以 $1.75/M 输入、$14/M 输出计费,并作为高阶默认模型供编码使用。Warp 与 Windsurf 报告在 Terminal‑Bench 2.0 上成绩突破 60 分,说明“终端 + agentic coding”这条路正在被 GPT‑5.2 明显推高上限。消息来源

Gemini Deep Research 代理与 Interactions API 面向开发者开放。Google 为 Gemini 推出 Deep Research 代理和全新的 Interactions API,提供统一接口管理模型与代理、支持服务端上下文、后台执行以及远程 MCP 工具。Deep Research 可以自动规划多步检索、浏览网页并产出结构化调研报告,定位在“面向工程师的自动化深度研究助手”,而不是简单的“加个搜索的聊天机器人”。消息来源

Claude Code 上线 Android 端并强化编辑体验。Claude 宣布 Claude Code 现已登陆 Android,并新增快捷键模型切换和在状态栏展示上下文窗口信息。配合 TestingCatalog 报道的 Android 研究预览版,这使“随身带着一位高级结对程序员”更加现实,移动端开发和随时 review 代码会更顺滑。消息来源

教程与技巧

nano banana Pro 提示词写作实战心得。宝玉总结了自己画了几百张 nano banana pro 图之后的提示词经验:核心不是堆形容词,而是先想清楚构图、主体、风格和信息密度,再把这些拆成结构化描述交给模型。对想靠 Gemini 3 / nano banana 做内容分发的人来说,这更像是在写“美术需求文档”,而不是随便一句“帮我画个海报”。消息来源

用 nano banana 做知识可视化,先想内容再画画。howie 强调,用 nano banana pro 画 PPT、信息图时,要遵守一个“第一性原理”:先把知识结构、要点和信息层级想清楚(最好配合 LLM 讨论),再让模型根据结构生成图像。这样基本可以“一稿过”,避免无限重试随机图片,实质上是把“画图”变成最后一步的渲染。消息来源

想搞懂 Nano Banana Pro 训练方法,先看阿里 6B 论文解读。向阳乔木提到,自己把阿里 6B 模型论文做成了一篇近 2 万字的中文解读,作为理解 nano banana Pro 背后训练思路的入口。对于想系统了解 Qwen/Nano Banana 这一路线如何在中等规模上做到“图像质量 + 控制力”的读者,这是比原始论文更易上手的材料。消息来源

Andrew Ng:几行代码做个“高度自治但超不可靠”的玩具 Agent。Andrew Ng 分享了一个基于开源 aisuite 的实验配方:给前沿 LLM 一两个工具(如磁盘访问、网页搜索),只用高层任务描述(写贪吃蛇游戏、做深度调研),然后放手让它自己乱跑。虽然这种方式远不符合生产级代理的工程要求,但很适合快速体会“没有严密 scaffold 的代理会如何失控”,也呼应他在 Agentic AI 课程里的理念。消息来源

想深入搞推理与加速,值得收藏的 GPU/推理学习资源。ℏεsam 推荐了一组学习底层 GPU 编程和推理引擎开发的开源 repo 清单,适合已经玩转 LLM 应用、想往下钻到 kernel-level 优化和自研推理框架的工程师。对未来想在“模型压缩、加速、部署”方向做深耕的人,这类资源比泛泛而谈的教程更重要。消息来源

Claude Code Skills/SubAgent 激活率低?社区提供的“强制激活三步曲”。nazha 总结了在 Claude Code 中使用 Skills 和 SubAgent 的踩坑经验:如果仅在 prompt 里“温柔”提一下可用技能,Claude 常常完全忽略。社区的做法是在 UserPromptSubmit hook 里强制要求模型先逐个评估技能,再显式执行 Skill() 调用,最后才开始实现任务,代价是更多 token 和注意力,但能把激活率提升到约 80%。消息来源

观点与思考

真实医疗问诊实验:Gemini 3 Pro > Qwen > ChatGPT 5.1。凡人小北用一批来自真实问诊场景的病人主诉与医生结论,分别让 Gemini 3 Pro、Qwen 和 ChatGPT 5.1 看诊后与真实结果对比,发现表现顺序依次为 Gemini 3 Pro 第一、Qwen 第二、ChatGPT 第三。结论是:在足够“模糊”和不整洁的真实世界数据中,模型差异反而被放大,benchmark 上差不多并不等于真实场景体验一致。消息来源

“真正难的是定义问题,而不是做智能体。”dontbesilent 用一个“把小说改成 80 分水平的剧本”需求调侃:如果你能用几千字严格定义什么是“小说”“剧本”“编剧”“剧本水平”和“80 分”,他可以 3 分钟做出这个智能体,而且在不同模型上结果无差别。真正难的是把语言游戏里的模糊概念说清楚,否则所谓“智能体需求”只是模糊愿望,无法工程化。消息来源

好用的 Agent,90% 在“记忆”,而不是模型。ℏεsam 认为,能真正工作的 Agent,关键不在框架、MCP 数量或模型大小,而在于它对自己“能做什么、要达成什么目标、过去犯过什么错”的持久记忆。他称这种长期、任务领域内的“workflow memory”为 Agent 的核心,把它设计好,能让同一个模型在行为上从“6 岁小孩”变成“严谨工程师”。消息来源

Benchmark 与“vibe”之间的张力。Jan 指出,AI 研究者迟早会发现:benchmark 成绩和真实使用时的“vibe”往往不一致。尤其是本地部署场景,硬件、插件和配置事实上是模型的一部分,小小不同就会改变体验。因此他强调要用自己的环境长期“感受”一个模型,而不是只看几组公开分数,这是对当下模型评估方法的一个现实主义提醒。消息来源